Etichettare i dati può essere un lavoro ingrato. È la principale fonte di sostentamento per i modelli di visione artificiale; senza di esso, si avrebbero molte difficoltà a identificare oggetti, persone e altre importanti caratteristiche dell’immagine. Tuttavia, produrre solo un’ora di dati etichettati può richiedere ben 800 ore di tempo umano.

Gli scienziati del Computer Science and Artificial Intelligence Laboratory (CSAIL) del MIT, di Microsoft e della Cornell University hanno tentato di risolvere questo problema che affligge i modelli di visione creando “STEGO“, un algoritmo in grado di scoprire e segmentare congiuntamente oggetti senza alcuna etichetta umana, fino al pixel.

STEGO impara qualcosa chiamato “segmentazione semantica”. La segmentazione semantica è un’abilità importante per i sistemi di visione artificiale di oggi perché le immagini possono essere ingombre di oggetti. Un sistema precedente potrebbe semplicemente percepire una scena sfumata di un cane che gioca nel parco come un semplice cane, ma assegnando a ogni pixel dell’immagine un’etichetta, STEGO può suddividere l’immagine nei suoi ingredienti principali: un cane, un cielo, erba e il suo proprietario.

Assegnare a ogni singolo pixel del mondo un’etichetta è ambizioso, soprattutto senza alcun tipo di feedback da parte degli umani. La maggior parte degli algoritmi oggi ottiene la propria conoscenza da cumuli di dati etichettati, che possono richiedere scrupolose ore umane per l’origine. Immagina l’emozione di etichettare ogni pixel di 100.000 immagini. Per scoprire questi oggetti senza la guida utile di un essere umano, STEGO cerca oggetti simili che appaiono in un set di dati. Quindi associa questi oggetti simili insieme per costruire una visione coerente del mondo attraverso tutte le immagini da cui impara.

Vedere il mondo

Le macchine in grado di “vedere” sono cruciali per una vasta gamma di tecnologie nuove ed emergenti come le auto a guida autonoma e la modellazione predittiva per la diagnostica medica. Poiché STEGO può imparare senza etichette, può rilevare oggetti in molti domini diversi, anche quelli che gli esseri umani non comprendono ancora pienamente.

“Se stai guardando scansioni oncologiche, la superficie dei pianeti o immagini biologiche ad alta risoluzione, è difficile sapere quali oggetti cercare senza conoscenze specialistiche. Nei domini emergenti, a volte anche gli esperti umani non sanno quali siano gli oggetti giusti”, afferma Mark Hamilton, dottorando in ingegneria elettrica e informatica al MIT, affiliato di ricerca del MIT CSAIL, ingegnere del software presso Microsoft e autore principale di un nuovo articolo su STEGO. “In questi tipi di situazioni in cui si desidera progettare un metodo per operare ai confini della scienza, non si può fare affidamento sugli esseri umani per capirlo prima che lo facciano le macchine”.https://www.youtube.com/embed/58uhMDO7dTQ?feature=oembed

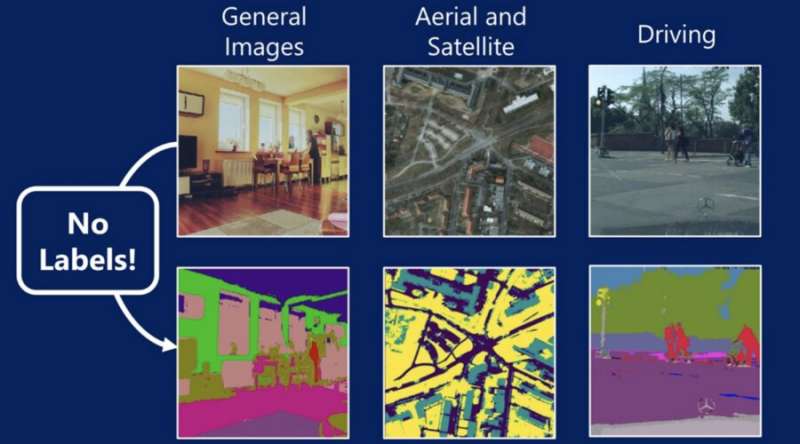

STEGO è stato testato su una serie di domini visivi che coprono immagini generali, immagini di guida e fotografie aeree ad alta quota. In ogni dominio, STEGO è stato in grado di identificare e segmentare oggetti rilevanti che erano strettamente allineati con i giudizi umani. Il punto di riferimento più diversificato di STEGO è stato il set di dati COCO-Stuff, che è composto da diverse immagini provenienti da tutto il mondo, dalle scene al coperto alle persone che praticano sport agli alberi e alle mucche. Nella maggior parte dei casi, il precedente sistema all’avanguardia poteva catturare un’essenza a bassa risoluzione di una scena, ma falliva su dettagli a grana fine: un essere umano era un blob, una motocicletta veniva catturata come persona ecc… Nelle stesse scene, STEGO ha raddoppiato le prestazioni dei sistemi precedenti e ha scoperto concetti come animali, edifici, persone, mobili e molto altro.

STEGO non solo ha raddoppiato le prestazioni dei sistemi precedenti sul benchmark COCO-Stuff, ma ha fatto passi da gigante simili in altri domini visivi. Applicato ai set di dati delle auto senza conducente, STEGO ha segmentato con successo strade, persone e segnali stradali con una risoluzione e una granularità molto più elevate rispetto ai sistemi precedenti. Sulle immagini dallo spazio, il sistema ha suddiviso ogni singolo metro quadrato della superficie della Terra in strade, vegetazione ed edifici.

Collegamento dei pixel

STEGO, che sta per “Self-supervised Transformer with Energy-based Graph Optimization”, si basa sull’algoritmo DINO, che ha imparato a conoscere il mondo attraverso 14 milioni di immagini dal database ImageNet. STEGO affina le abilità di DINO attraverso un processo di apprendimento che imita il nostro modo di mettere insieme pezzi del mondo per dare essi un significato.

Ad esempio, potreste prendere in considerazione due immagini di cani che camminano nel parco. Anche se sono cani diversi, con proprietari diversi, in parchi diversi, STEGO può dire (senza l’ausilio di umani) come gli oggetti di ogni scena si relazionino tra loro.

“L’idea è che questi tipi di algoritmi possano trovare raggruppamenti coerenti in modo in gran parte automatizzato, quindi non dobbiamo farlo da soli”, afferma Hamilton. “Potrebbero esserci voluti anni per comprendere set di dati visivi complessi come le immagini biologiche, ma se possiamo evitare di passare 1.000 ore a setacciare i dati ed etichettarli, possiamo trovare e scoprire nuove informazioni che potremmo aver perso. Speriamo che questo ci aiuti a capire la parola visiva in un modo più empiricamente fondato”.

Guardando avanti

“Nel creare uno strumento generale per comprendere set di dati potenzialmente complicati, speriamo che questo tipo di algoritmo possa automatizzare il processo scientifico di scoperta di oggetti dalle immagini. Ci sono molti domini diversi in cui l’etichettatura umana sarebbe proibitivamente costosa, o gli esseri umani semplicemente non conoscono nemmeno la struttura specifica, come in alcuni domini biologici e astrofisici. Speriamo che il lavoro futuro consenta l’applicazione a un ambito molto ampio di set di dati. Dal momento che non c’è bisogno di ausilio umano, ora possiamo iniziare ad applicare gli strumenti ML in modo più ampio”, afferma Hamilton.

“STEGO è semplice, elegante e molto efficace. Considero la segmentazione non supervisionata un punto di riferimento per i progressi nella comprensione delle immagini e un problema molto difficile. La comunità di ricerca ha fatto progressi formidabili nella comprensione delle immagini non supervisionate con l’adozione di architetture di trasformatori”, afferma Andrea Vedaldi, professore di visione artificiale e apprendimento automatico e co-leader del Visual Geometry Group presso il dipartimento di scienze ingegneristiche dell’Università di Oxford. “Questa ricerca fornisce forse la dimostrazione più diretta ed efficace di questi progressi sulla segmentazione non supervisionata”.

Hamilton ha scritto il documento insieme allo studente di dottorato del MIT CSAIL Zhoutong Zhang, all’assistente professore Bharath Hariharan della Cornell University, al professore associato Noah Snavely della Cornell Tech e al professore del MIT William T. Freeman. Presenteranno il documento alla Conferenza internazionale sulle rappresentazioni dell’apprendimento (ICLR) del 2022.